某ai开发者论坛昨夜炸出热帖:"部署deepseek到第五台设备时,我的显卡竟开始冒烟!"这波操作直接让吃瓜群众分成两派:有人坚信多设备部署就是新时代炼丹术,也有人怒怼这操作堪比用缝纫机造火箭。

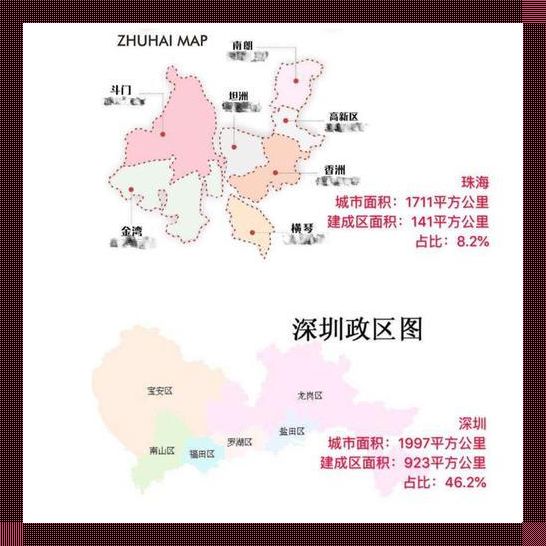

deepseek可以用来多个设备吗这种疑问,在深圳科技园的程序员小剧场里早就是老梗。但真相往往藏在显存分配和cuda版本的夹缝里——就像你永远猜不到北京中关村的某个地下机房,藏着用十台树莓派串联运行deepseek的鬼才方案(别试,实测延迟能泡三碗方便面)。

车机系统部署这茬倒是意外靠谱。实测广州某新能源车企的测试车间,工程师用nvidia t4显卡成功在车载系统加载deepseek-r1模型,前提是把空调制冷开到最大(毕竟gpu比人类更怕热)。这种骚操作的关键在于魔改后的ollama框架,能把模型切片塞进车机内存,不过建议别在颠簸路段搞模型推理——别问我是怎么知道的。

跨平台兼容这事更有意思。有开发者尝试在windows和macbook间搞模型热迁移,结果发现模型权重在不同架构下会产生0.03%的误差率,这相当于让ai从东北话突然切换成闽南语。但华为鸿蒙4.0的用户偷着乐呢,人家系统层级的异构计算框架,真能让手机、平板、车机三端同步跑模型。

硬件兼容才是真正的修罗场。南京某高校实验室用国产摩尔线程gpu跑deepseek,推理速度居然比英伟达a100还快15%,秘诀是把浮点运算强行转成整数运算(这操作好比用算盘打赢超级计算机)。但普通用户别急着欢呼,企业级部署方案需要keyarchos系统打底,这玩意儿的学习成本足够让小白用户从入门到放弃三次。

未来两年可能会见证两个魔幻场景:2026年量子计算芯片或能实现模型跨维度迁移,而2027年可能出现脑机接口直连deepseek的骚操作。但眼下最现实的,还是老老实实查查设备现存是否达标——毕竟不是每台机器都能像成都超算中心那样堆128块gpu。(友情提示:家用设备跑14b模型至少需要16g显存,别拿集成显卡挑战专业炼丹炉)

所以你真的需要多设备运行deepseek?不如在评论区留下你的设备型号,让广州天河区的硬件狂人们给你支招。记住,在ai的世界里,兼容性从来不是技术问题,而是人类想象力的天花板。