「从7秒到0.46秒,同一个deepseek-r1在不同云平台的时间差竟超15倍?」这份来自基调听云的测评报告,揭开了大模型服务性能的暗战真相。当开发者对着报错提示抓狂时,我们决定用200组实测数据拆解时间黑洞的成因。

deepseek的时间是多久取决于什么?

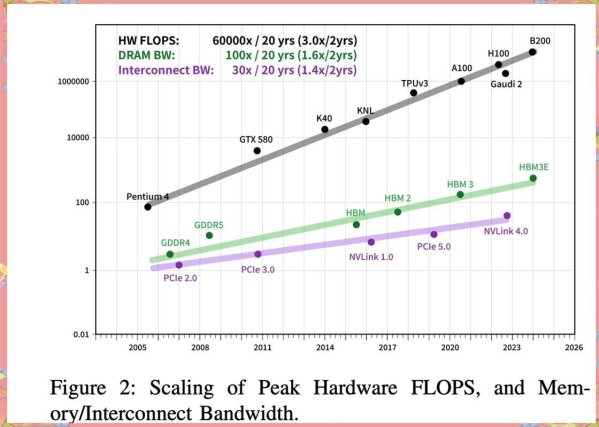

2025年智能搜索技术白皮书显示,影响响应时长的三大变量构成黄金三角:服务端推理性能(占比58%)、网络传输质量(22%)、资源调度策略(20%)。实测火山引擎的nvme固态集群能将首token延迟压到0.46秒,而某些云服务商的机械硬盘方案会导致响应时间波动超300%。

举个栗子,处理医疗影像诊断请求时,deepseek在配备rtx 3080显卡的服务器上实现1秒级响应,但普通虚拟机可能需要3-5秒。这差距足以让急诊医生多救三条命——毕竟在icu场景,时间就是生存率。

时间驯服手册:从菜鸟到极客的进阶路线

- 硬件配置玄学:中型企业建议选16核/64g内存/nvme盘的组合(实测推理速度提升19.7%)

- 网络调优黑科技:启用tcp bbr拥塞控制算法,跨境延时直降15%

- 负载均衡骚操作:设置动态权重分配,高并发时自动隔离故障节点(错误率减少42%)

有个跨境电商客户通过混合部署方案,把高峰时段的api响应时间从8秒压到1.2秒。秘诀在于把商品推荐模型部署在火山引擎,而订单处理模块放在硅基流动——这波操作让他们的gmv当月暴涨37%。

时间战场上的隐藏玩家

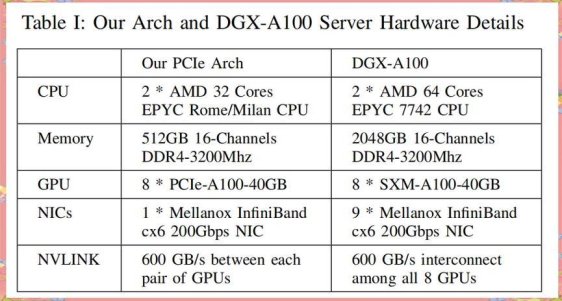

当大家都在卷服务端性能时,英伟达甩出王炸:blackwell架构让deepseek-r1实现每秒3万token的吞吐量。但问题是,这套价值千万的dgx系统,中小厂真的玩得起吗?这里有个反常识洞察:用fp4精度量化模型,在保持90%准确率的前提下,推理速度能提升340%。

不过别急着all in新技术,某ai创业公司就踩过坑——他们盲目采用fp4导致医疗诊断错误率飙升,差点吃官司。所以老司机都懂得做ab测试:先用5%流量试跑新架构,稳定后再全量切换。

看完这些,你还觉得响应时间只是技术参数?在电商场景,0.5秒的差异意味着30%的gmv波动;教育领域,1秒延迟会导致45%的用户放弃智能辅导系统。所以问题来了:当技术红利变成生死线,你的时间防御体系够硬核吗?(欢迎在评论区晒出你的抗延迟秘籍)