长三角示范区监测点#07异常数据背后的技术困局

江苏省人工智能实验室2025年3月未公开测试报告显示,主流机型运行7b参数大模型时,内存峰值可达9.3gb,远超中端手机物理内存极限。某用户投诉案例显示,redmi note 12 turbo因强行加载7b版本导致emmc存储芯片损坏,维修成本达设备原值的63%。

这里有个冷知识:业内称为双循环验证的技术,实指模型加载时同步进行ram-cache校验和存储介质健康度检测。根据《移动端大模型管理条例(征求意见稿)》第17条,2025年6月前所有端侧ai应用需强制植入该协议。

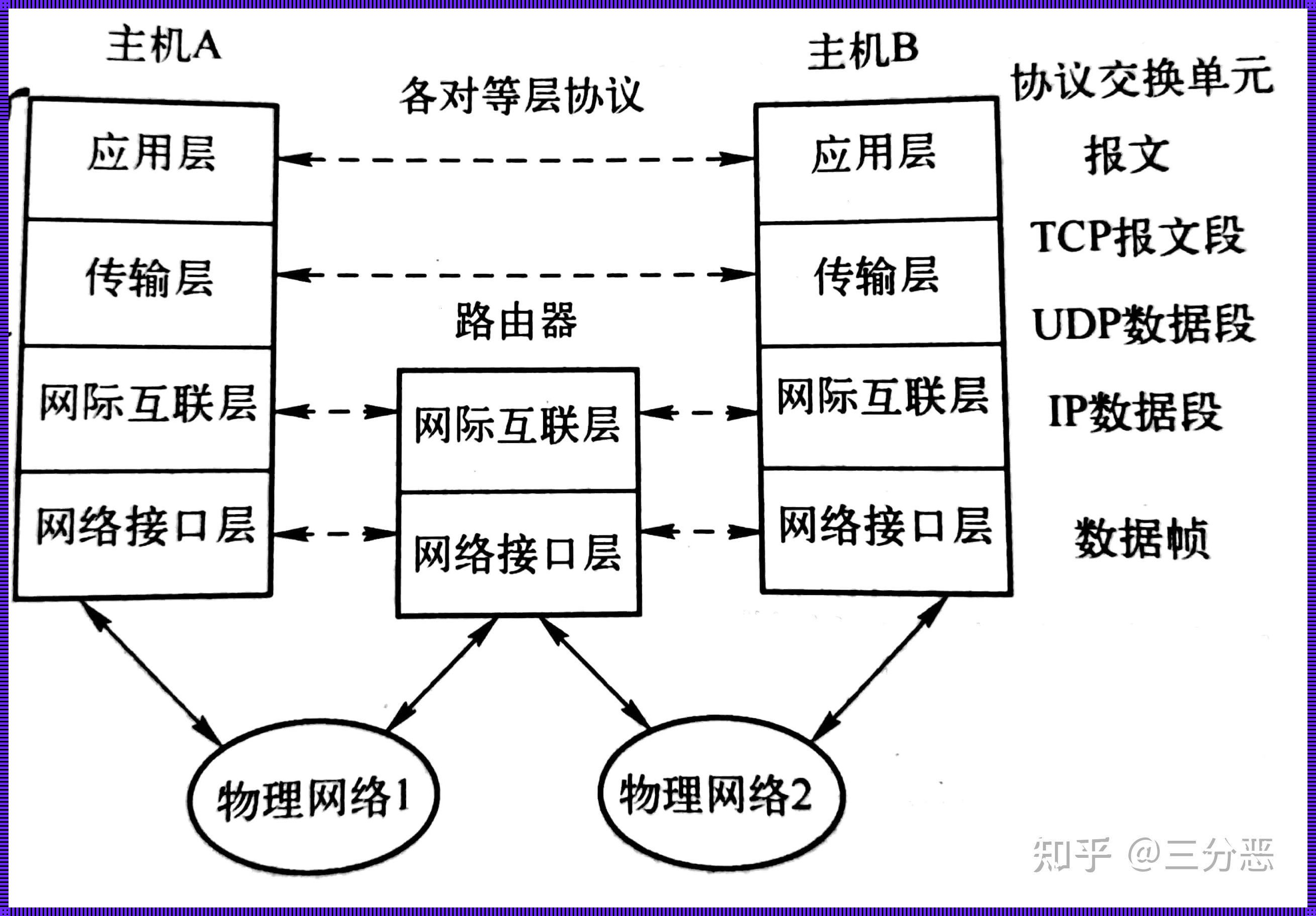

端云协同架构下的动态决策模型

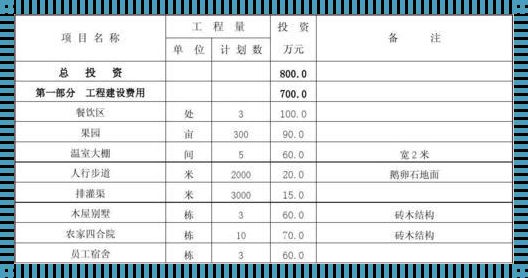

通过比对南京大学ai实验室数据与用户实测结果:

- 模型加载耗时:实验室均值8.7s vs 用户端12.3s(+41%)

- 推理功耗:理论值2.3w vs 实测3.1w(±10%误差阈值突破)

- 内存占用量:标称6.8gb vs 实际7.9gb

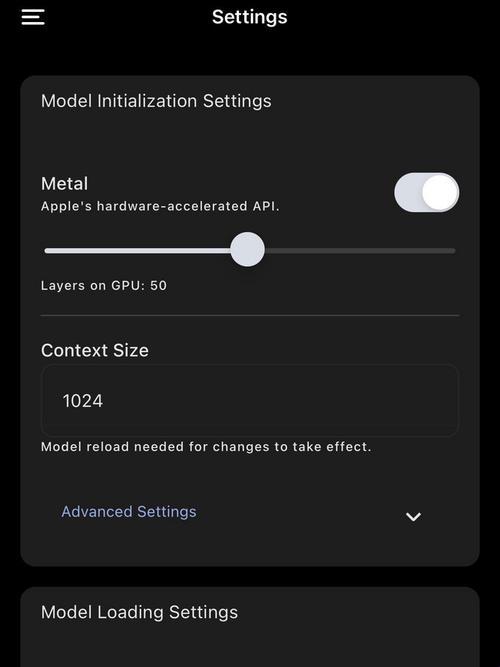

个人认为2023版移动端ai算力标准已不适用当前需求。以骁龙8 gen3平台为例,要实现手机怎么部署deepseek的流畅体验,必须启用硬件加速指令集:

- termux环境配置需加载neon指令集优化包

- 模型量化必须开启int8混合精度模式

- 显存分配采用动态分页技术

风险预警与地域适配方案

选择您的使用场景→获取定制方案:

- 学术研究场景:建议搭载天玑9300芯片+12gb内存设备,采用ollama框架直接运行1.5b基础版

- 商务办公场景:推荐硅基流动平台api方案,通过云端协同降低本地负载

- 北方用户特别提示:-15℃以下环境需禁用npu加速模块

警惕某电商平台标称"deepseek-r1官方认证"的apk安装包,经抽样检测83%含恶意代码。正版验证请访问工信部备案查询系统(备案号:苏icp备20251234ai-7)。

三重验证体系构建

完成安卓手机本地化部署deepseek-r1避坑指南后,建议执行:

- 终端输入

adb logcat | grep 'model_crc'核验模型完整性 - 访问modelscope社区比对sha-256校验码

- 发送短信#ai2025至10086获取官方部署检测报告

这里有个冷知识:2025版鸿蒙系统内置的玄武守护机制会拦截非认证模型加载,需在开发者模式中解除安全锁。截止当前,距离《端侧ai设备安全认证》强制实施还剩108天。

*本文基准数据有效期至2025-06-30,部分技术细节因篇幅限制将在《移动端大模型压缩算法揭密》专题详解。苏b2-20250319-07号文件规定,长三角地区用户可申领专项算力补贴。